Percepção visual e imagem digital

Luan Magioli, março de 2024

A percepção e (mais afundo) a construção da realidade são processos complexos realizados pelo cérebro

animal. A visão é um dos sentidos mais importantes para a sobrevivência, dado que a maioria dos animais

depende da luz para se orientar no ambiente.

A visão é fruto de um fenômeno físico, que envolve a interação da luz com a matéria;Mas para entender como nós demos o dom da visão às máquinas, precisamos entender como nós, humanos, enxergamos e interpretamos o mundo ao nosso redor (além de como este mundo funciona).

É um fenômeno psicológico, que envolve a interpretação dos sinais captados pelas retinas;

É fenômeno digital, que envolve a captura, armazenamento e processamento de imagens.

A luz e a visão humana

A luz é uma forma de energia eletromagnética composta por fótons - partículas que se movem em ondas - e por

causa disso, ela tem propriedades tanto de partículas quanto de ondas, um fenômeno conhecido como wave-particle duality.

O interessante sobre isso é que dependendo da superfície e das propriedades do fóton, apenas uma fração da

luz incidente que é refletida. Chamamos isso de refletância. Por exemplo, um espelho tem alta refletância,

enquanto o carvão tem baixa refletância.

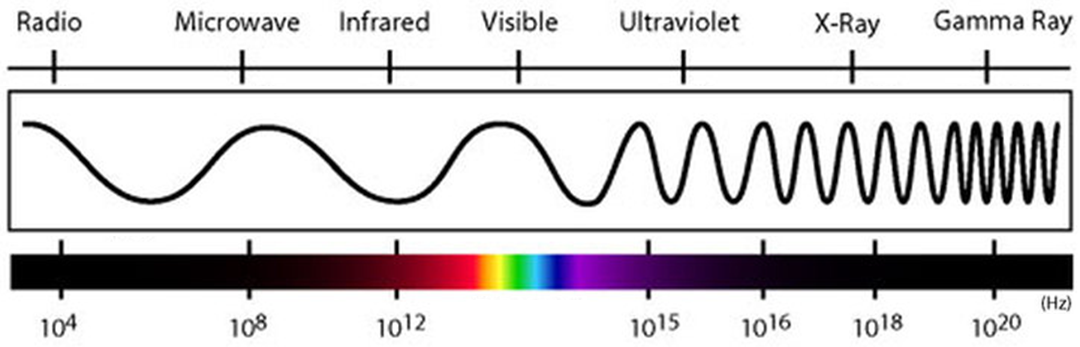

As ondas de luz podem ser descritas por suas propriedades físicas, como comprimento de onda,

frequência e amplitude. A luz visível, aquela que conseguimos enxergar, tem comprimento de

onda entre 400 e 700 nanômetros. Mas a luz não é apenas aquilo que conseguimos ver, ela é composta por um

espectro eletromagnético que vai desde as ondas de rádio até os raios gama.

Ainda sobre refletância: diferentes materiais conseguem reter partículas em ondas de luz de diferentes comprimentos. Por exemplo, a clorofila absorve a luz azul e vermelha, refletindo a luz verde. Isso é o que dá a cor verde às plantas.

É por causa disso que cada material tem uma cor diferente.

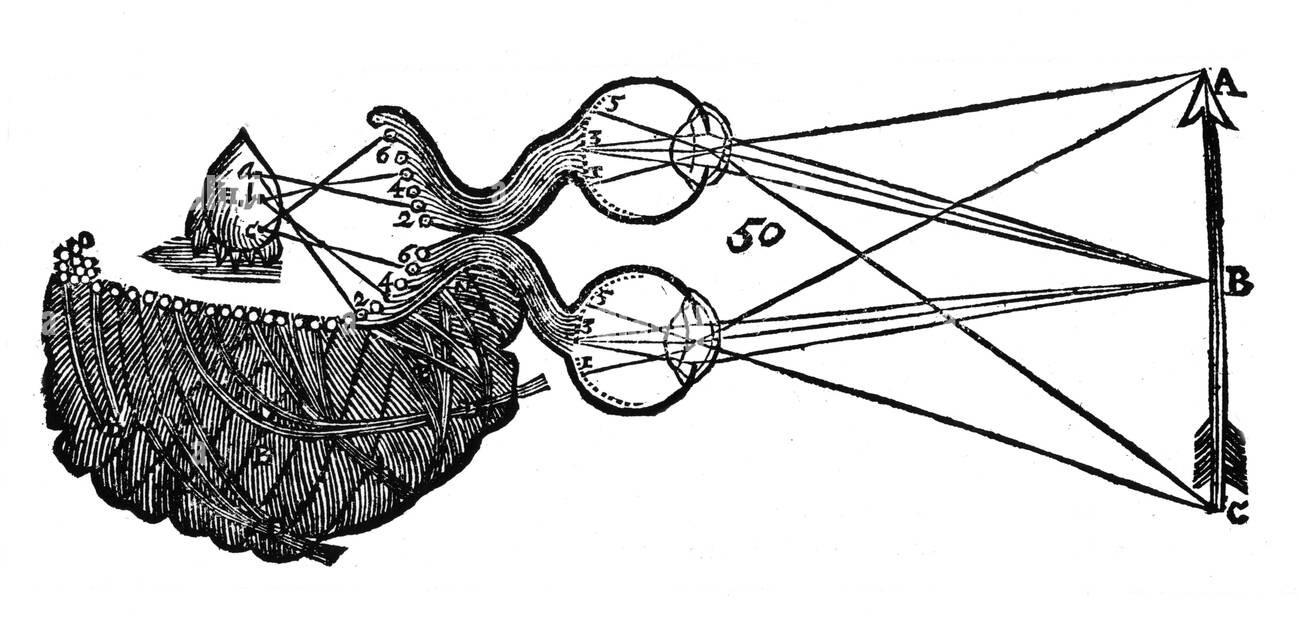

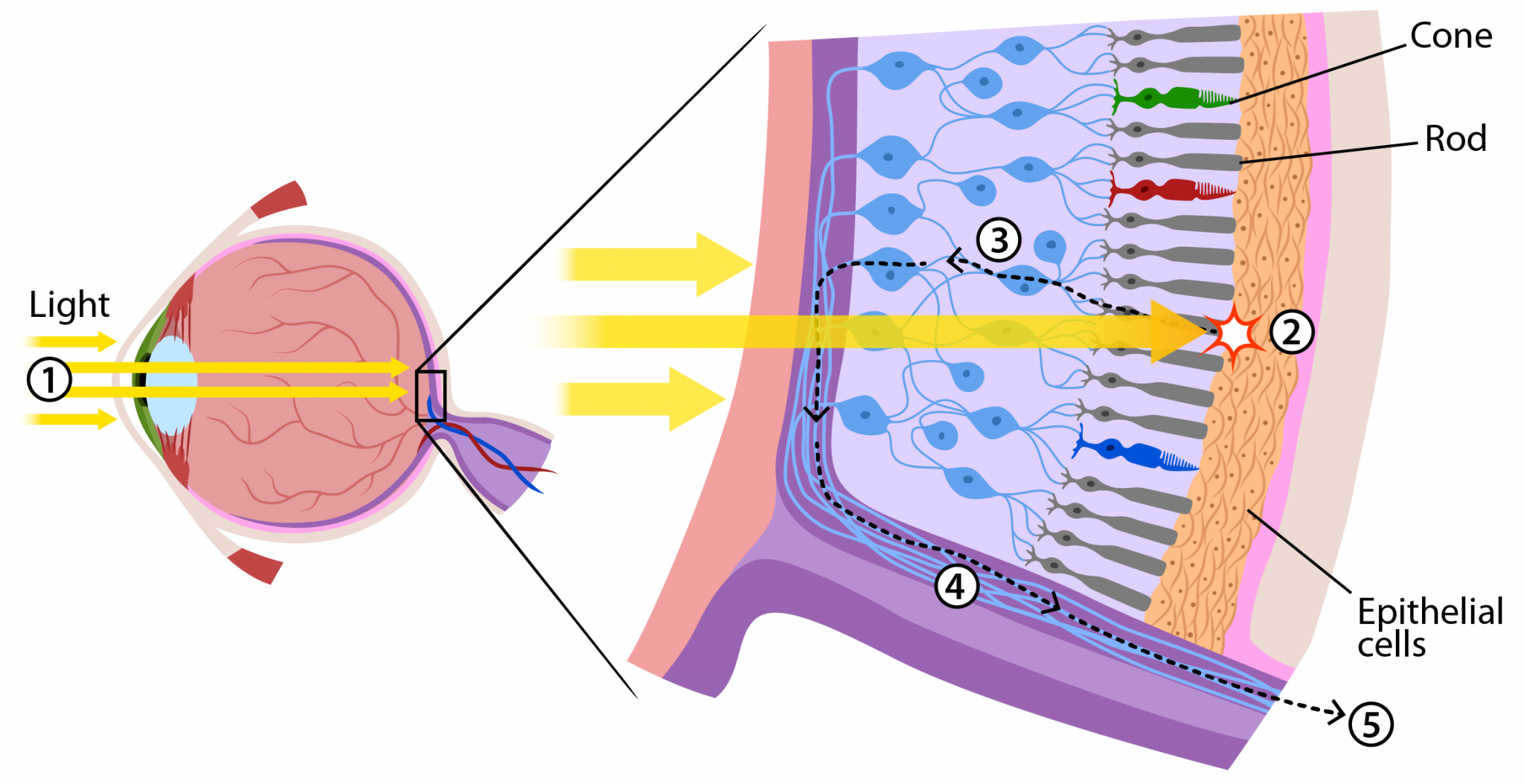

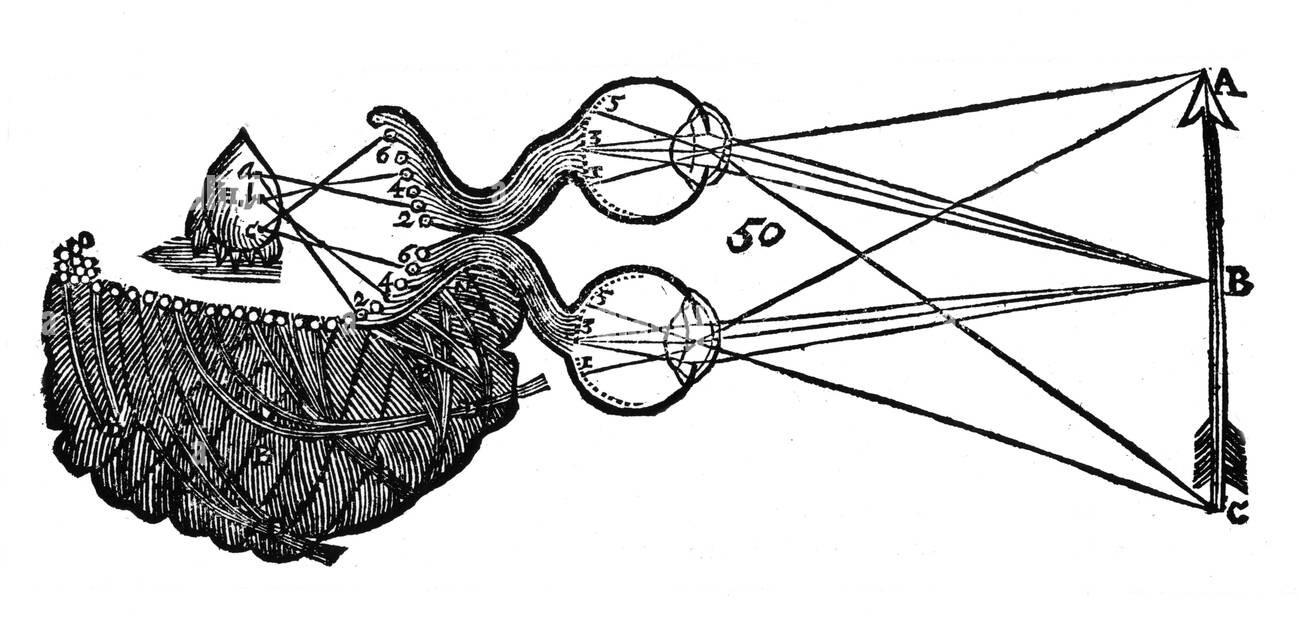

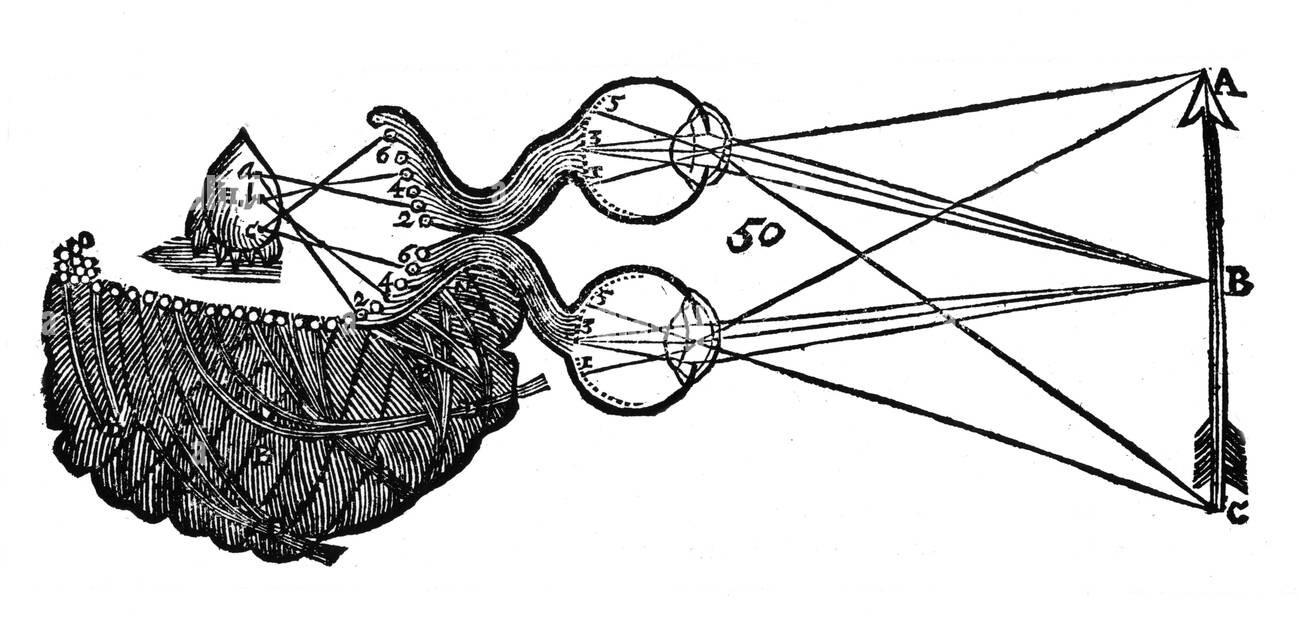

O olho humano é um órgão composto por diversas estruturas que desempenham funções específicas. A luz entra através da córnea, passa pelo cristalino e atinge a retina, onde é convertida em sinais químicos/elétricos que são enviados ao cérebro através do nervo óptico. O cérebro, por sua vez, interpreta esses sinais e (com muito trabalho) constrói a imagem que vemos. Decartes foi um dos primeiros a descrever este processo, que ele chamou de visão cartesiana.

Para codificar a informação visual, o cérebro utiliza um sistema de coordenadas chamado retinotópico, que mapeia a posição dos objetos no campo visual. Estes sinais são enviados pela retina, que é composta por células fotorreceptoras chamadas cones e bastonetes, as responsáveis por captar a luz e transformá-la em sinais elétricos. Os cones são responsáveis pela visão dos detalhes finos e de cores (ondas vermelhas, verdes e azuis), enquanto os bastonetes são responsáveis pela visão periférica e noturna (o que você enxerga ao fechar os olhos).

Entender isso é importante para a visão computacional. As máquinas não enxergam como nós, mas os sensores desenvolvidos para capturar imagens tentam imitar o olho humano.

A realidade é um engruminhado de ruídos e sinais, nós não enxergamos o mundo como ele é, mas sim como o

cérebro interpreta, isso depende de diversos fatores, como a iluminação, a distância, o ângulo, a cor, a

textura, entre outros. (Quando você está calmo ou estressado, você enxerga o mundo de maneiras

diferentes, não é? Apois, o buraco é bem mais fundo...)

Além disso, estamos sujeitos as limitações do nosso sistema visual e nervoso, que é muito bom em

algumas coisas, mas péssimo em outras (lembra das ilusões de ótica?). Por exemplo, nós somos muito

bons em identificar padrões, mas péssimos em medir distâncias.

Sensores e imagens digitais

Olha, deixando de lado a possibilidade de dar uma aula de história sobre a fotografia, apenas trago uma colagem histórica que achei interessante. As imagens vão até a década de 70, quando algum engenheiro da Kodak inventou a primeira câmera digital.

- Primeira fotografia por Joseph Nicéphore Niépce, 1826.

- Primeira fotografia colorida por James Clerk Maxwell, 1861.

- Imagem codificada por uma impressora telegráfica e transmitida por um cabo no oceano atlântico em 1921.

- Primeira imagem digitalizada por Russell Kirsch, 1957

- Primeira fotografia da terra vista da lua por uma sonda espacial, 1966.

Toda fotografia é uma representação física/digital da realidade, ela organiza um ponto de vista da cena de acordo com a posição e intensidade da luz no sensor. A fotografia digital é uma evolução da analógica (óbvio), utilizando sensores eletrônicos para capturar a intensidade da luz em um determinado ponto no espaço e a transformam em sinais elétricos.

Pretendo abordar mais sobre os sensores multiespectrais (fora do espectro visível) em um artigo futuro, mas por enquanto, vamos focar nos sensores digitais.

Existem alguns

dois tipos de sensores eletrônicos que conseguem capturar o espectro visível, os sensores CCD e CMOS. E não

vou gastar meu tempo explicando eles enquanto Captain Disillusion já

lançou a braba.

(sério, assista o vídeo...)

A imagem em meios digitais é formada por uma matriz bidimensional onde cada elemento é chamado de

pixel. Cada pixel é composto por um valor de intensidade luminosa, que pode ser representado por um

valor numérico.

O "nível de detalhes" presente na realidade é infinito, com o auxílio de microscópios e telescópios

conseguimos ver coisas que o olho humano não consegue. Mas uma máquina não consegue armazenar uma quantidade

infinita de informação, então é necessário discretizar a informação em valores finitos, ou seja,

limitar a quantidade de cores e a resolução da imagem. Só pra constar, este processo é chamado de

amostragem/quantização.

A quantidade de bits por pixel é chamada de profundidade de cor, e é um dos fatores que determina a qualidade da imagem. Nós humanos conseguimos diferenciar 256 tons de cinza (8 bits), que distribuidos em 3 canais (RGB) resultam em 16 milhões de cores.

A resolução de uma imagem é dada pelo número de pixels na horizontal e na vertical, e é medida em pixels por

polegada (ppi), quanto maior a resolução, mais detalhes são capturados.

Podemos dizer matematicamente que uma imagem digital é uma função bidimensional f(x, y), onde x e y são as coordenadas espaciais e o valor de f a intensidade luminosa. Representa-la dessa maneira nos ajuda a adaptar técnicas clássicas da matemática e processamento de sinais para a análise de imagens. Vou trazer mais sobre isso nos próximos artigos.

Bom...

Espero que tenha ajudado a entender um pouco mais sobre a visão e a imagem digital, e que tenha despertado a curiosidade para aprender mais sobre o assunto. Recomendo muito a leitura dos capítulos iniciais do livro Processamento Digital de Imagens de Gonzales e Woods, que é uma referência na área.

Até a próxima!

Compartilhe com seus amigos nerdolas.